Представьте, что мощный инструмент для работы с текстом и кодом теперь не где-то в облаке, а прямо на вашем компьютере. Без сложных подписок и необходимости в постоянном интернете. Именно это и предлагает Ollama, превращая сложные технологии в доступный для каждого инструмент.

Суть технологии: ваш личный ИИ-помощник

Ollama – это специальная платформа, которая позволяет запускать и использовать большие языковые модели локально. Представьте её как удобную оболочку, которая скрывает всю техническую сложность. Вам не нужно быть программистом или специалистом по машинному обучению, чтобы начать с ней работать.

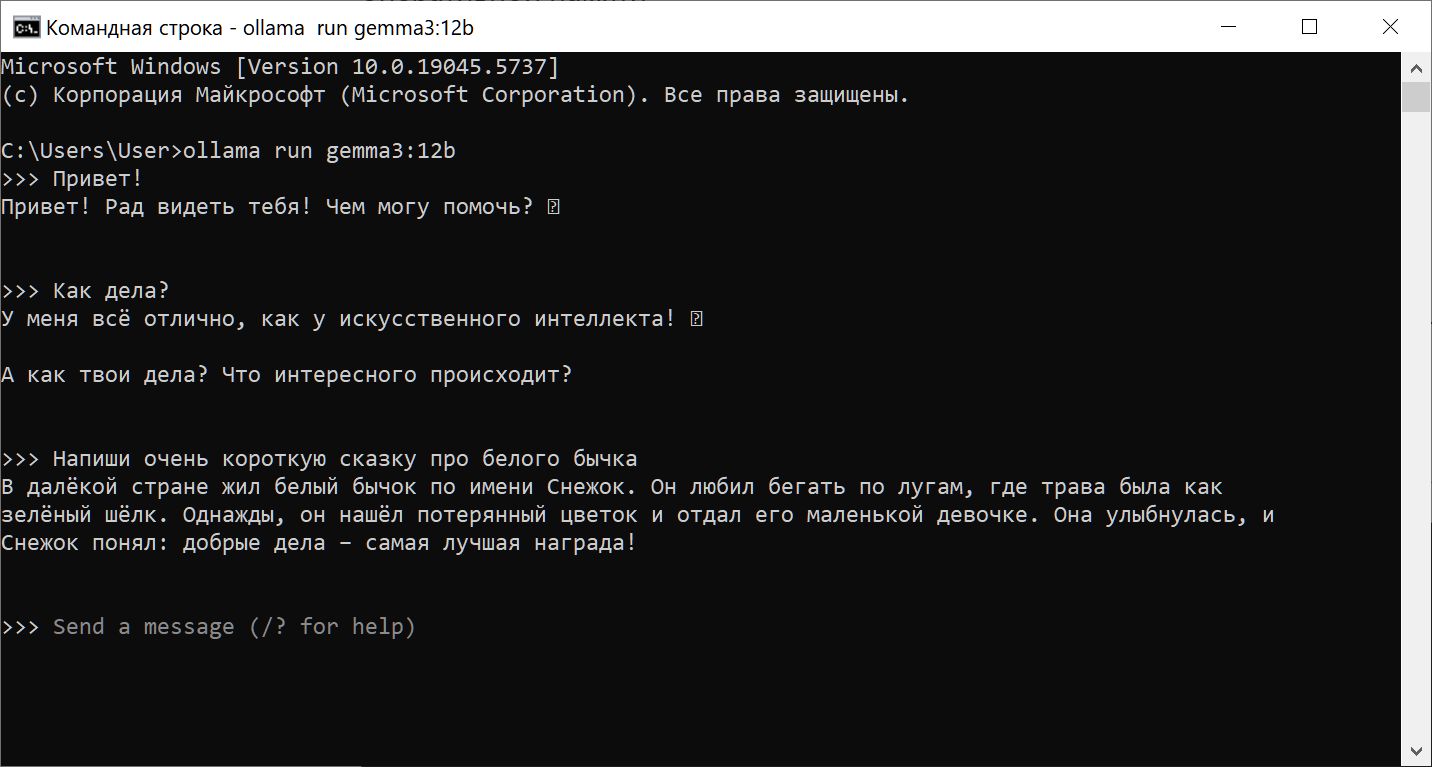

С помощью командной строки или специального интерфейса вы получаете доступ к возможностям современных нейросетей, таких как Llama или Mistral. Они буквально оживают на вашем собственном устройстве, готовые к диалогу.

На что способна локальная модель?

Функционал напрямую зависит от выбранной вами модели. Однако в целом спектр задач впечатляет. Это не только генерация текста для писем, статей или творческих проектов, но и анализ информации, переводы между языками, помощь в написании кода.

Модель может выступать в роли собеседника, репетитора или ассистента, помогая решать логические задачи и даже генерировать идеи. Многие используют её для автоматизации рутинных операций с текстом, экономя время и силы.

Какое оборудование потребуется?

Здесь всё определяется масштабом модели. Для знакомства с технологией подойдёт даже обычный ноутбук. Минимальная конфигурация включает 8 ГБ оперативной памяти и современную операционную систему, будь то Windows, Linux или macOS.

Для комфортной работы с более продвинутыми версиями лучше располагать 16 ГБ памяти и выше. Наличие дискретной видеокарты с хорошим запасом памяти (от 6 ГБ) кардинально ускорит процесс обработки запросов. Также не забудьте про свободное место на диске – модели могут занимать десятки гигабайт.

Простая установка за пару минут

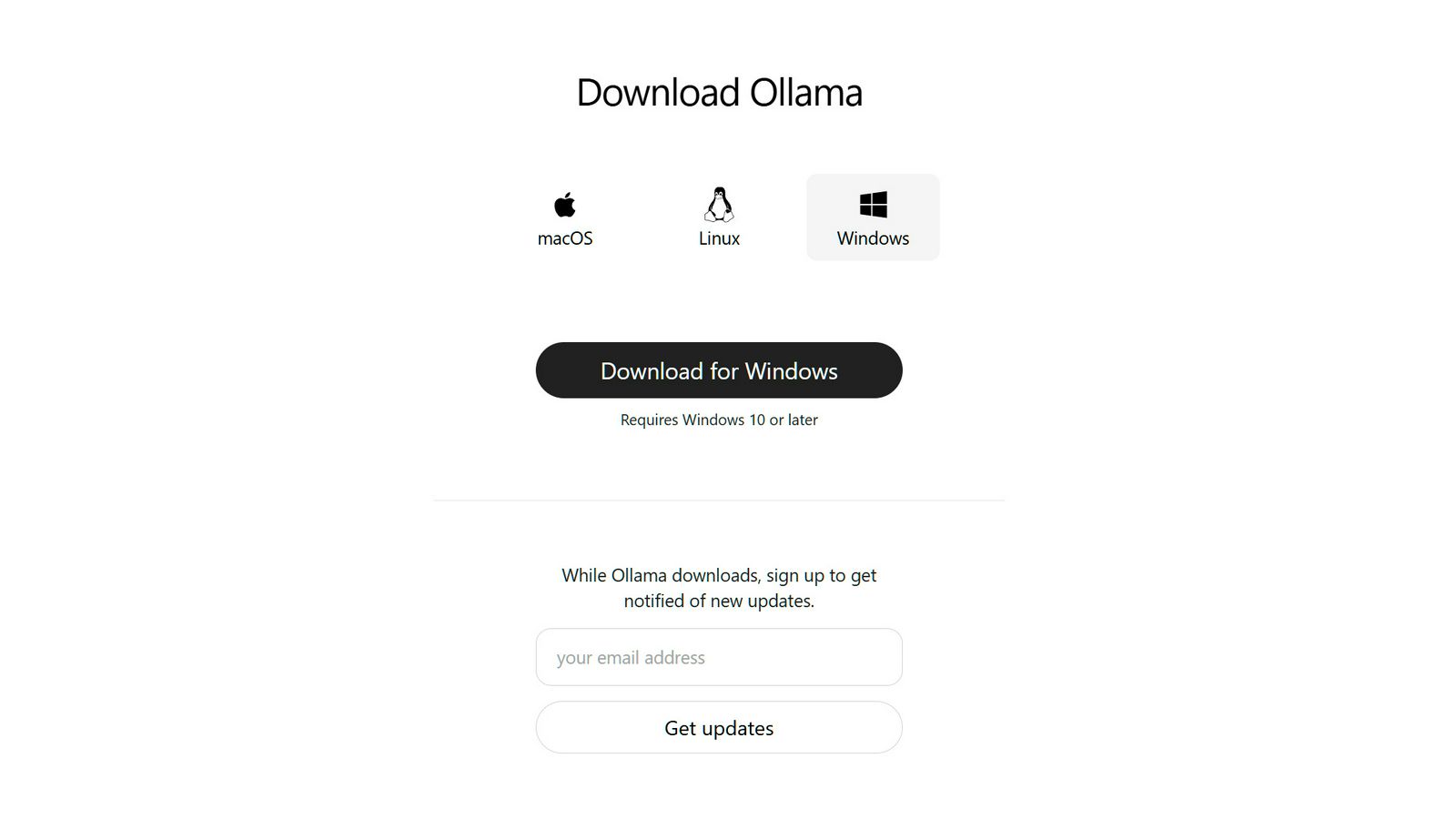

Начать работу проще простого. Первым делом зайдите на официальный сайт проекта и скачайте установочный файл, соответствующий вашей системе. Запустите его и следуйте подсказкам мастера установки. Платформа самостоятельно настроит всё необходимое для корректной работы.

После завершения установки можно сразу переходить к тестированию. Откройте терминал или командную строку и введите:

ollama helpчтобы увидеть список доступных команд. Это подтвердит, что система готова к использованию.

Первые шаги и запуск модели

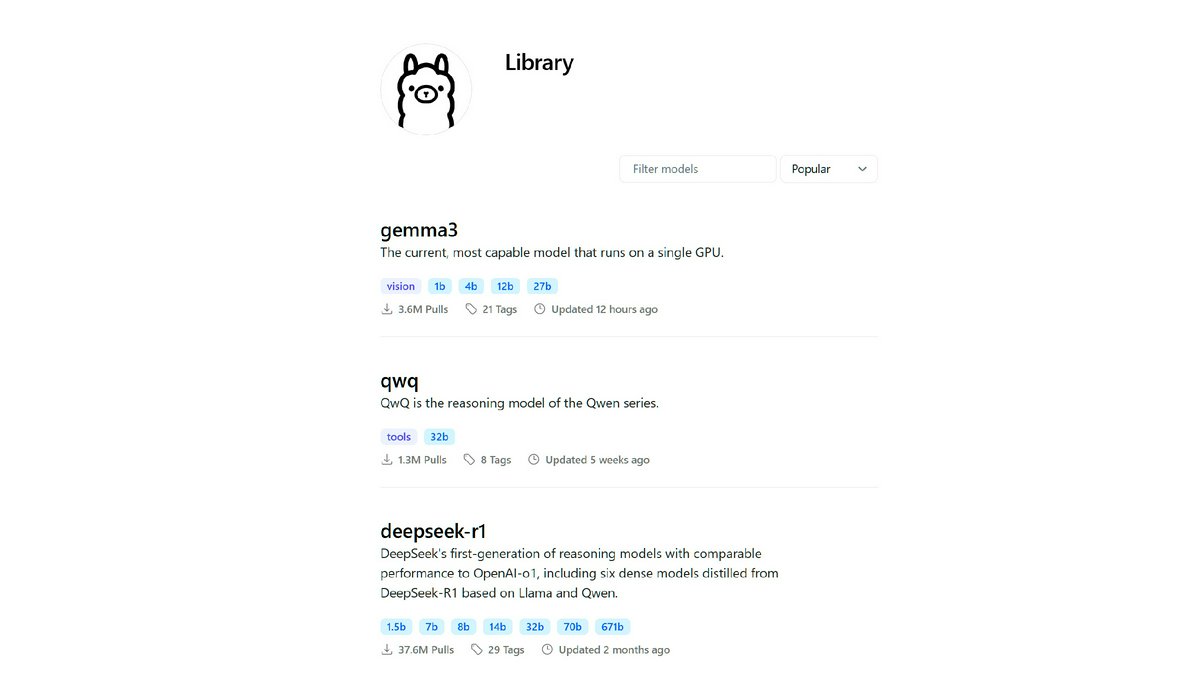

Теперь нужно выбрать и загрузить саму языковую модель. На сайте проекта есть целая библиотека с различными вариантами.

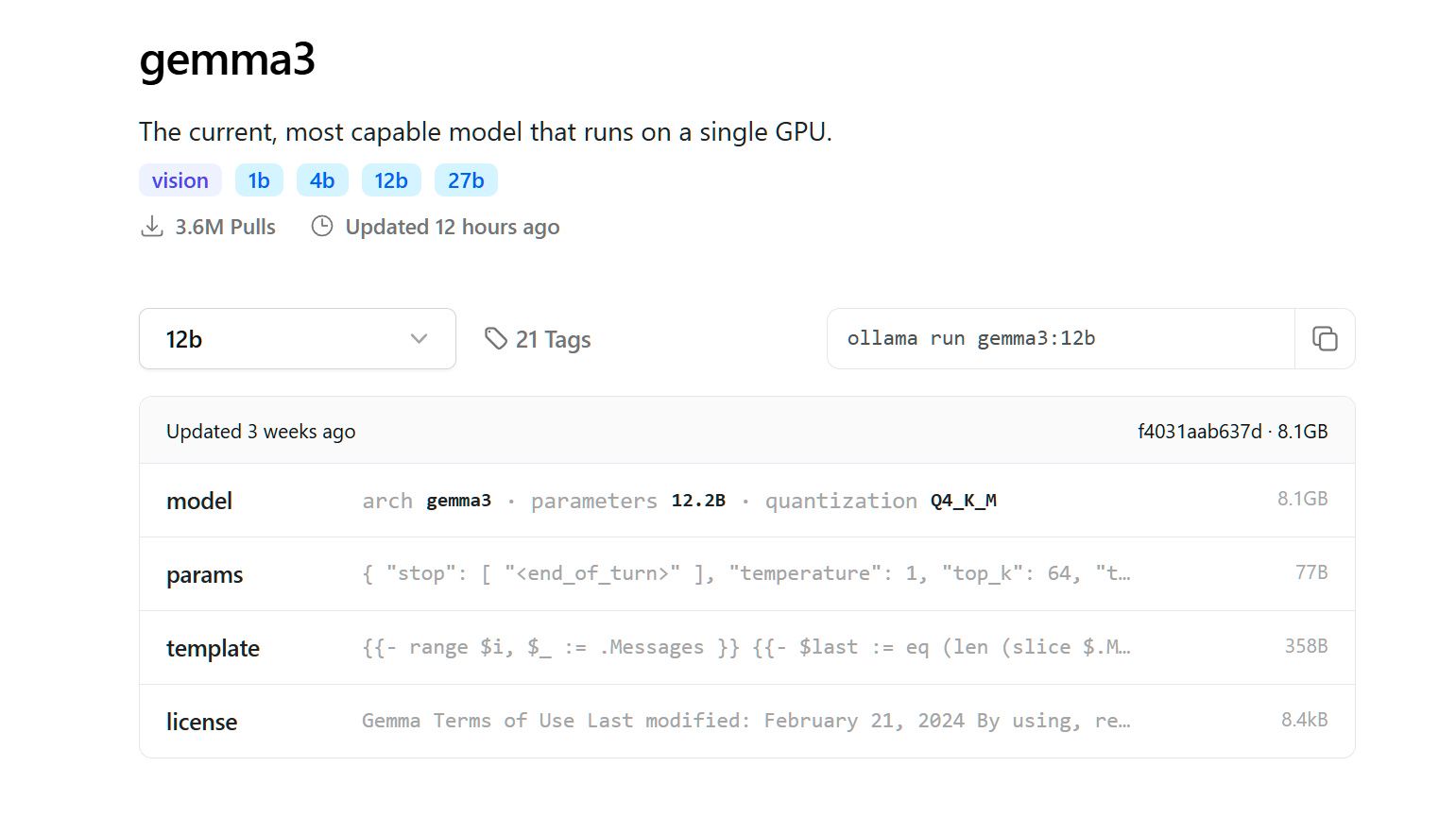

Для её загрузки введите в терминале команду:

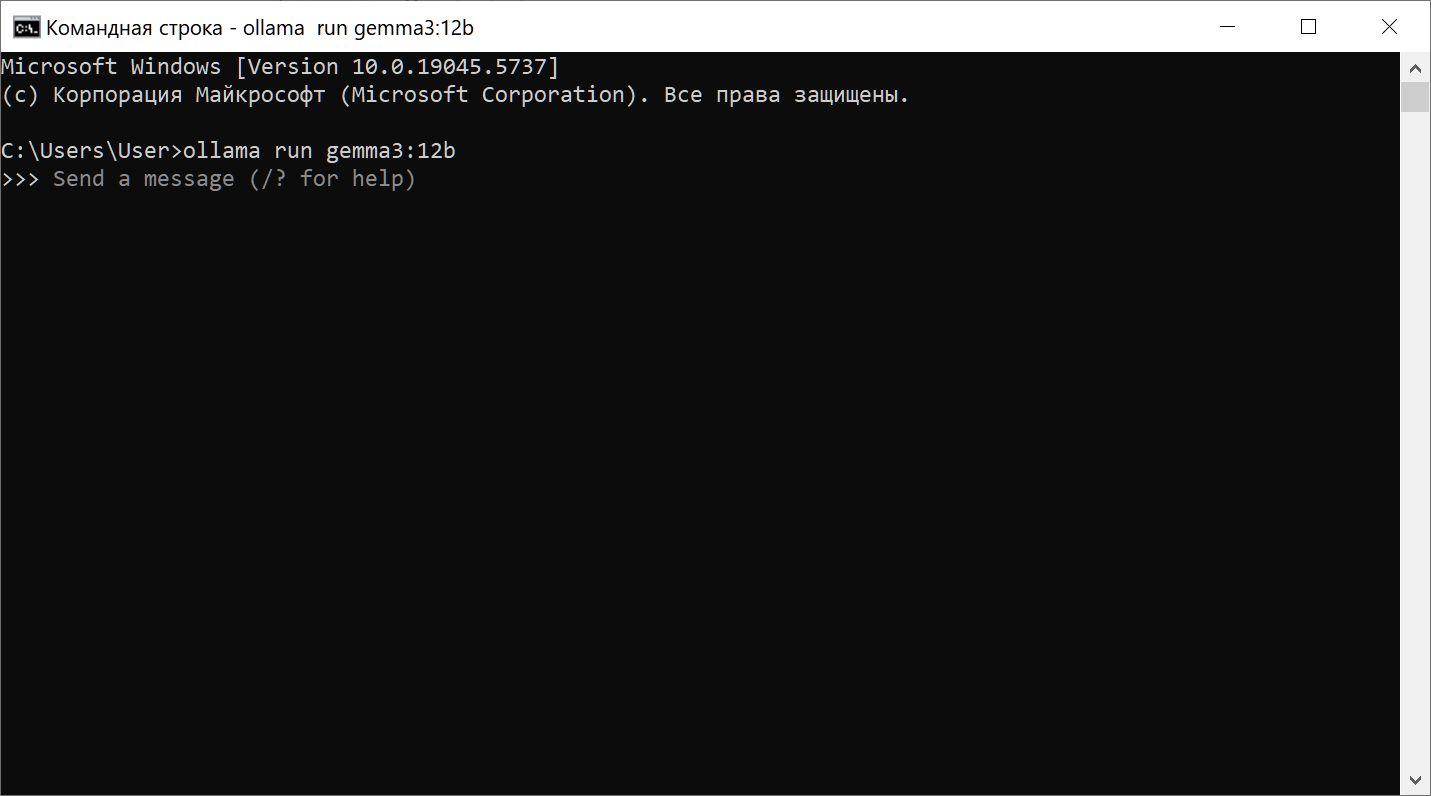

ollama run gemma3:12bСистема начнёт скачивание файлов модели на ваш жесткий диск. Дождитесь завершения процесса. Как только загрузка закончится, интерфейс командной строки изменится, приглашая вас задать первый вопрос. Просто введите его с клавиатуры и нажмите Enter.

Модель обработает запрос и сгенерирует ответ прямо в терминале. Вы можете продолжать диалог, задавая новые вопросы. Таким образом, вы получаете полноценный чат с искусственным интеллектом, работающий полностью автономно на вашем ПК.

Что дальше?

Стандартный интерфейс – это лишь начало. Для повседневной работы существуют удобные графические оболочки, которые делают общение с моделью более наглядным. А при желании можно даже настроить удаленный доступ через Telegram-бота или другие инструменты.

Ollama стирает барьеры для знакомства с передовыми технологиями. Это возможность экспериментировать, учиться и находить нестандартные применения для языковых моделей в своих проектах. Попробуйте запустить её сегодня и откройте новые горизонты прямо на своём компьютере.

Если хотите глубже погрузиться в тему, узнать про удобные графические интерфейсы или настройку удаленного доступа, ищите наши следующие материалы.